Но если у вас крупный проект, то оптимизация краулингового бюджета жизненно необходима, поскольку окажет влияние на ранжирование сайта в поисковых системах. В противном случае может оказаться, что часть вашего сайта не проиндексирована и не участвует в поиске». План размещения страниц сайта влияет на частоту (или полное отсутствие) их сканирования. Чем важнее страница, тем выше по уровню вложенности её необходимо располагать.

- Необходимо убедиться, что в файле robots.txt открыты для индексации все нужные страницы и скрыты все лишние ссылки с помощью директив Allow и Disallow соответственно.

- Наглядные графики и анализ отчетов помогут выявить возможные проблемы при сканировании, а также отследить изменения или проблемы краулингового бюджета.

- Однако каждый компьютер или программа имеет ограниченные ресурсы.

- Проблема в том, что работает это только для Яндекс, и всё равно требует времени.

- Добавьте в sitemap.xml правило lastmod для страниц, контент которых остался прежним с момента последней индексации.

Поясняем — бот увидит первую ссылку, а вторую — после перехода на нее. И только после этого перейдет на страницу с правильным URL. Если речь о крауд-маркетинге, ссылки необходимо размещать только на трастовых сайтах, которым доверяют поисковики. И даже если пользователю кажется, что анкорная ссылка выглядит более естественно, увы, поисковые системы считают наоборот — они ценят безанкорные ссылки. В первой части статьи рассказывали, как посчитать краулинговый бюджет, а в этой — остановимся на советах, которые помогут предотвратить или устранить технические ошибки на сайте. Это оптимизирует краулинговый бюджет и положительно повлияет на ваши позиции в выдаче.

Если на сайте много страниц, не факт, что бот их проиндексирует все — он может проиндексировать ошибочные, а на важные не хватит времени и бюджета. Поисковые системы считаются одним из лучших источников бесплатного трафика. Вы создаёте оптимизированный контент, его сканируют поисковые системы, и он начинает ранжироваться. На первый взгляд весь процесс прост, и большинству не стоит беспокоиться о нюансах, связанных со сканированием сайта. Добавьте в sitemap.xml правило lastmod для страниц, контент которых остался прежним с момента последней индексации.

Лендинг В Топе: 9 Особенностей Seo-продвижения

Познакомимся с определениями этих понятий и различиями между ними. Указать в карте сайта приоритет важных страниц через атрибут . Это позволит роботам понять, какие страницы наиболее важны и приоритетны в индексировании. Когда поисковые роботы заходят на новую или обновлённую страницу, они должны отсканировать весь контент от кода до картинок и отправить его в индекс.

Во-вторых, это приводит к трате ссылочного веса и расходу краулингового бюджета. Во время сканирования бот может найти дубли страниц — одну и ту же страницу под разными URL-адресами. Заголовок Last-Modified сообщает браузеру пользователя или роботу ПС информацию о дате и времени последнего изменения текущей страницы.

Почему Краулинговый Бюджет Важен?

Еще одна проблема, которая может замедлить частоту сканирования веб-сайта, связана с наличием слишком большого числа редиректов. Подобно дублированному контенту, еще один фактор, который может повлиять на бюджет сканирования, — это тонкие страницы контента. Тем самым, роботы впустую тратят свое время на сканирование страниц, краулинговый бюджет которые затем поисковики пометят как дублированный контент.

Периодически проверяйте sitemap.xml – в ней не должно быть удаленных страниц, URL с перенаправлениями и ошибками. Чтобы избавиться от дублей окончательно, нужны более радикальные меры, чем директивы для ботов. Оптимально – оценить возможность удаления дублирующегося контента. Получить ссылки с других сайтов непросто, на самом деле это один из самых сложных аспектов в search engine optimization https://deveducation.com/, но это сделает ваш сайт сильнее и улучшит общее web optimization.

Мы решили рассмотреть подробнее этапы определения краулингового бюджета, чтобы с их помощью Вы могли понять, если ли ошибки в этом направлении и исправить их. Молодые сайты получают минимальное количество лимитов, достаточное для того, чтобы Юзабилити-тестирование поисковик смог оценить первоначальное качество ресурса, скорость публикации новых материалов и т.д. Мы собрали наиболее часто встречающиеся вопросы, касательно краулингового бюджета сайта. Особое отношение со стороны краулеров к 500-м кодам ответа, которые означают, что ресурс временно недоступен.

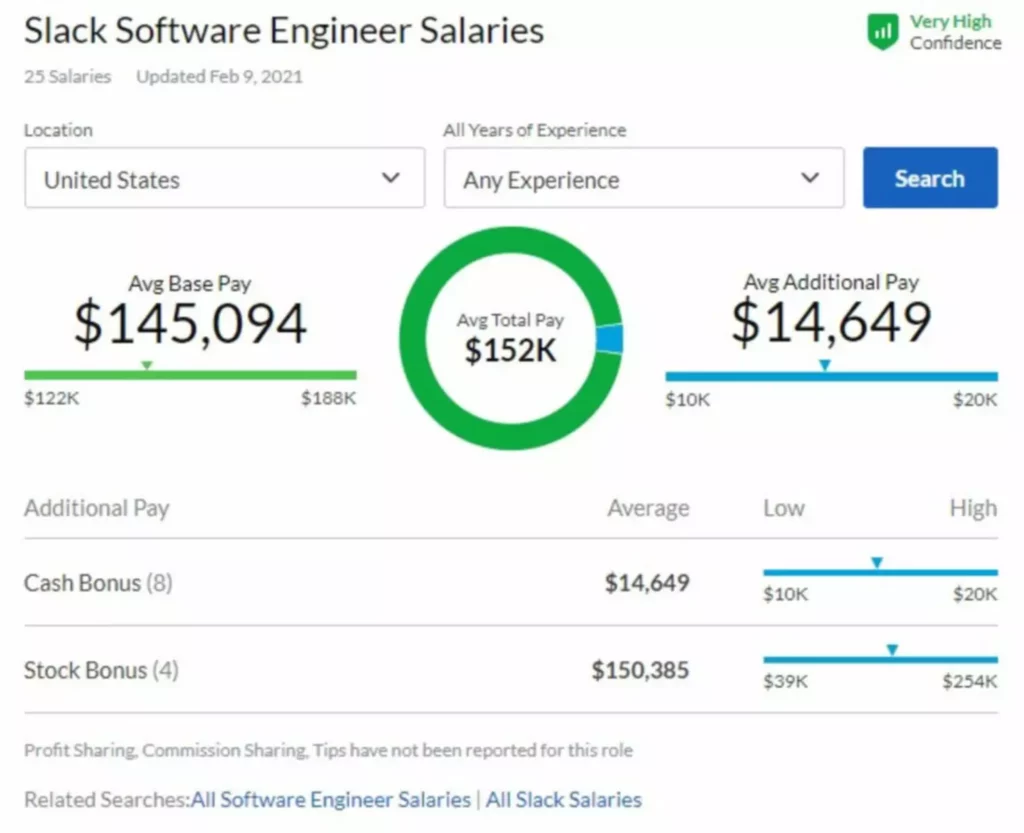

Данный показатель может изменяться в ту или иную сторону, но как приблизительный индикатор очень полезен. Графики со статистическими данными появятся в новом окошке. Среди них для вас важен будет первый — «Всего запросов на сканирование». Сегодня, вследствие ракетных ударов, каждый из нас столкнулся с ежедневными отключениями или тревогой из-за возможных отключений электроэнергии. Да, в панелях вебмастеров есть специальные настройки, в которых можно задавать ограничения на скорость индексирования.

В нашем случае запоминаем цифру 6 051, она пригодится для дальнейших расчетов. С ситуацией нехватки бюджета может столкнуться как крупный, так и маленький сайт. Чтобы этого не произошло, используйте файл robots.txt для устранения динамических бесконечных категорий.

Выберите соцсеть, которую роботы хорошо сканируют и постоянно мониторят, и закиньте туда ссылочку. Самый простой вариант – это активная «хлебная крошка», обозначающая саму страницу. Лучше всего снять с неё активную ссылку, чтобы она работала только как навигация, показывая посетителю, где именно он находится в данный момент. Но можно вовсе её убрать, юзабилити от этого не пострадает.

Иерархическая структура сайта с глубиной не более 3-х уровней является идеальной структурой любого веб-сайта. Тем не менее, вы можете оптимизировать свой краулинговый бюджет. Так робот сможет быстрее найти и отсканировать нужные страницы.